tokenDatabase = ({

"Der Hund liegt auf dem": [

{token: "Boden", prob: 0.32},

{token: "Sofa", prob: 0.24},

{token: "Bett", prob: 0.18},

{token: "Teppich", prob: 0.14},

{token: "Rasen", prob: 0.12}

],

"Die Katze sitzt auf dem": [

{token: "Dach", prob: 0.28},

{token: "Baum", prob: 0.24},

{token: "Sofa", prob: 0.20},

{token: "Tisch", prob: 0.16},

{token: "Fensterbrett", prob: 0.12}

],

"Die Studierenden lernen für die": [

{token: "Prüfung", prob: 0.45},

{token: "Klausur", prob: 0.25},

{token: "Zukunft", prob: 0.12},

{token: "Vorlesung", prob: 0.10},

{token: "Karriere", prob: 0.08}

]

})

viewof selectedSentence = Inputs.select(Object.keys(tokenDatabase), {

label: "Satzanfang:",

value: "Der Hund liegt auf dem"

})

currentProbs = tokenDatabase[selectedSentence]

viewof temperature = Inputs.range([0.1, 2.0], {

value: 1.0,

step: 0.1,

label: "Temperature"

})

scaledProbs = {

const t = temperature;

const logits = currentProbs.map(p => Math.log(p.prob));

const scaled = logits.map(l => Math.exp(l / t));

const sum = scaled.reduce((a, b) => a + b, 0);

return currentProbs.map((p, i) => ({token: p.token, prob: scaled[i] / sum}));

}Frage 1: Was ist KI?

Wie funktionieren Sprachmodelle wirklich?

Was sind Chatbots?

Was sind LLMs?

Ein LLM kann man sich wie einen ausgefeilten Autocomplete-Mechanismus vorstellen.

Die Kernidee

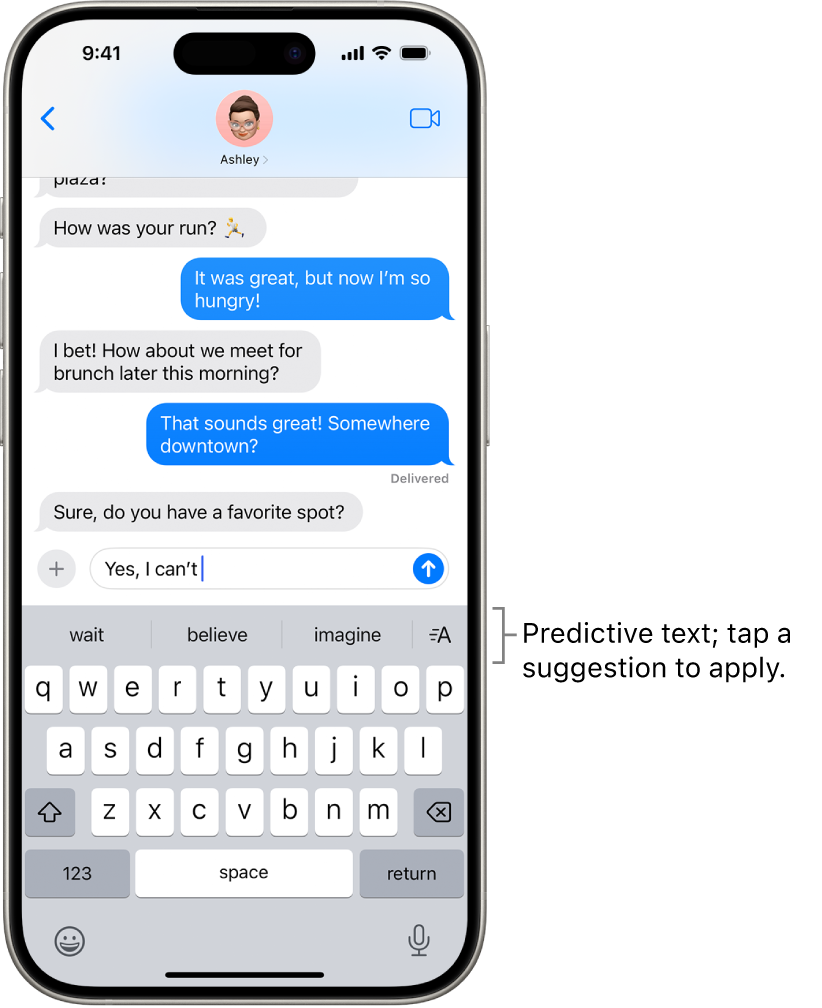

Sprachmodelle sagen das nächste Wort vorher.

\[ \newcommand{\green}[1]{\color{green}{#1}} \newcommand{\purple}[1]{\color{purple}{#1}} \newcommand{\red}[1]{\color{red}{#1}} \newcommand{\blue}[1]{\color{blue}{#1}} \]

\[\green{P(\text{Wort}_{i+1}} \mid \red{\text{Kontext}}, \blue{\text{Modell}})\]

Jede Vorhersage basiert auf dem Kontext und dem internen Modell.

Was bedeutet das konkret?

Gegeben einen Satzanfang wie “Der Hund liegt auf dem”, berechnet das Modell die Wahrscheinlichkeit für jedes mögliche nächste Wort:

- “Boden” → 32%

- “Sofa” → 24%

- “Bett” → 18%

- …

Zwei Faktoren bestimmen diese Vorhersage:

- Kontext: Was wurde bisher gesagt?

- Modell: Was hat das System aus Trainingsdaten gelernt?

Token-Vorhersage und Temperatur

Basis-Wahrscheinlichkeiten

Plot.plot({

marginLeft: 80,

width: 380,

height: 150,

x: {domain: [0, 0.5], label: "Wahrscheinlichkeit", tickFormat: d => (d * 100) + "%"},

y: {label: null},

marks: [

Plot.barX(currentProbs, {y: "token", x: "prob", fill: "#A3195B", sort: {y: "-x"}}),

Plot.text(currentProbs, {y: "token", x: "prob", text: d => (d.prob * 100).toFixed(0) + "%", dx: 5, textAnchor: "start"})

]

})Mit Temperature =

Plot.plot({

marginLeft: 80,

width: 380,

height: 150,

x: {domain: [0, 1], label: "Angepasste Wahrscheinlichkeit", tickFormat: d => (d * 100) + "%"},

y: {label: null},

marks: [

Plot.barX(scaledProbs, {y: "token", x: "prob", fill: "#D4A03E", sort: {y: "-x"}}),

Plot.text(scaledProbs, {y: "token", x: "prob", text: d => (d.prob * 100).toFixed(0) + "%", dx: 5, textAnchor: "start"})

]

})Vorhersage in Aktion

Nicht alle Teile des Kontexts sind gleich wichtig:

“Die Familie, die sehr wohlhabend war, lebte in einem grossen Haus. Das Haus stand inmitten eines weitläufigen Gartens. Es war bekannt für seine prächtige Fassade und die grosszügigen _“

Welche Wörter sind besonders wichtig für die Vorhersage?

Wie generieren LLMs ganze Sequenzen?

\[\green{P(\text{Wort}_{i+1}} \mid \red{\text{Kontext}}, \blue{\text{Modell}})\]

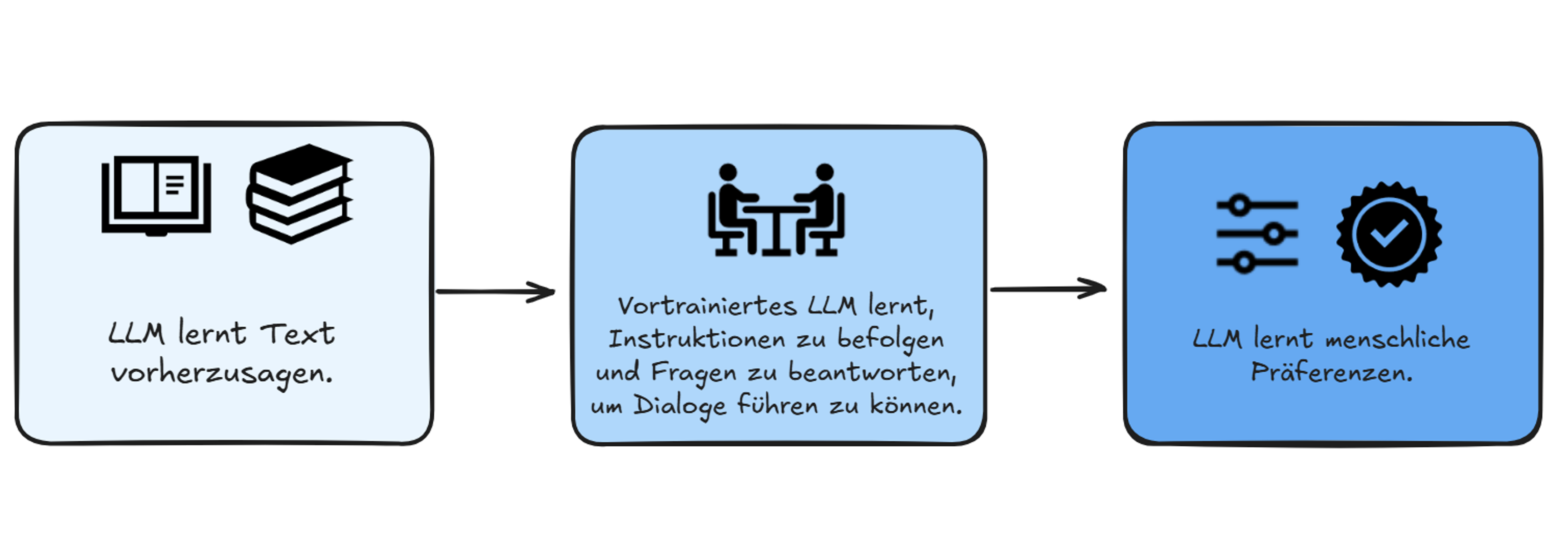

Wie werden LLMs trainiert?

Chain-of-Thought “Denken”

Wenn wir das Modell auffordern, “Schritt für Schritt zu denken”:

- Es generiert Zwischenschritte als zusätzliche Tokens

- Diese Tokens erweitern den Kontext für die nächste Vorhersage

- Mehr Kontext führt zu besseren Vorhersagen

Das “Denken” ist zusätzliche Textgenerierung. Dieser Text dient als erweiterter Kontext.

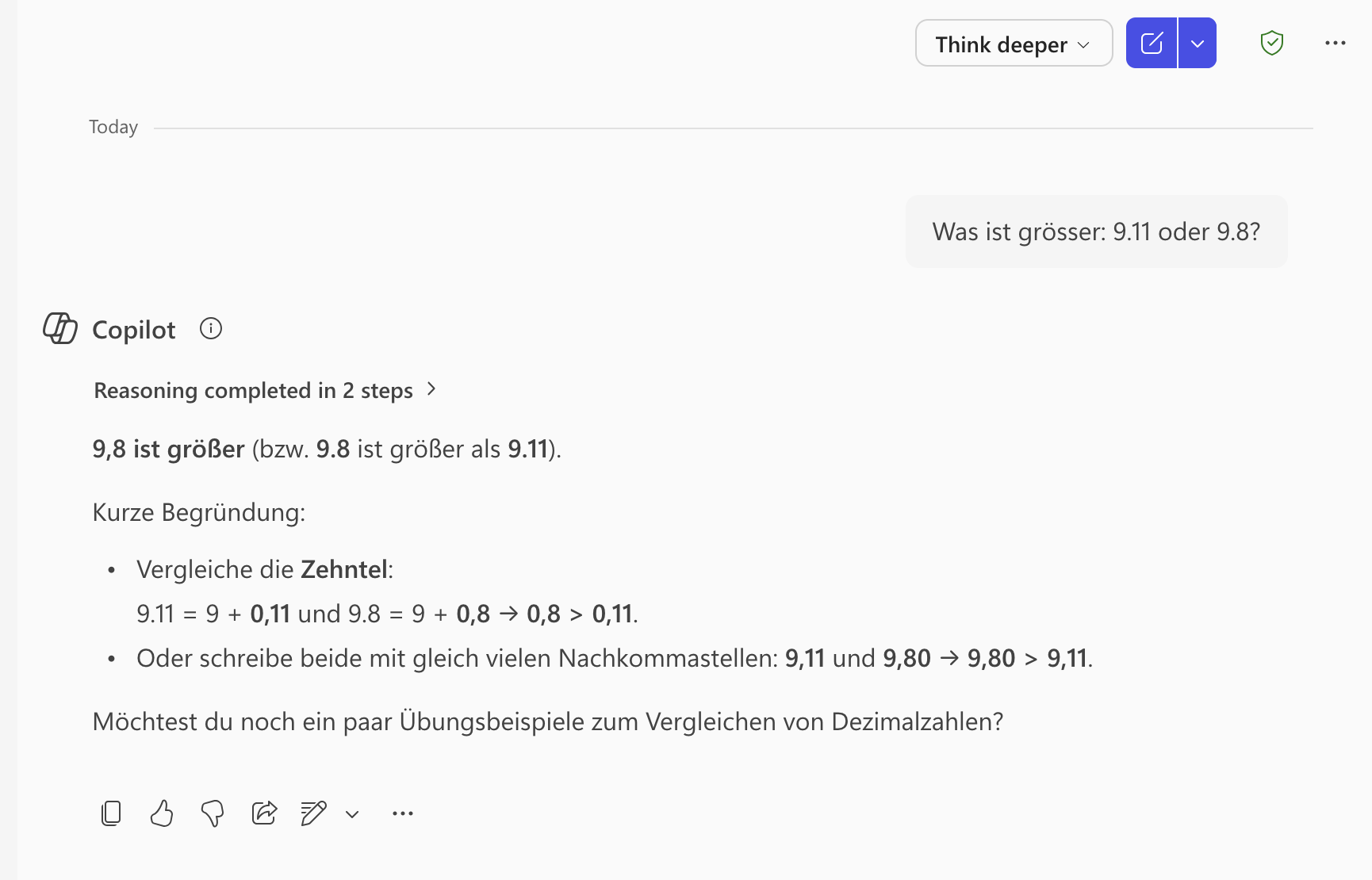

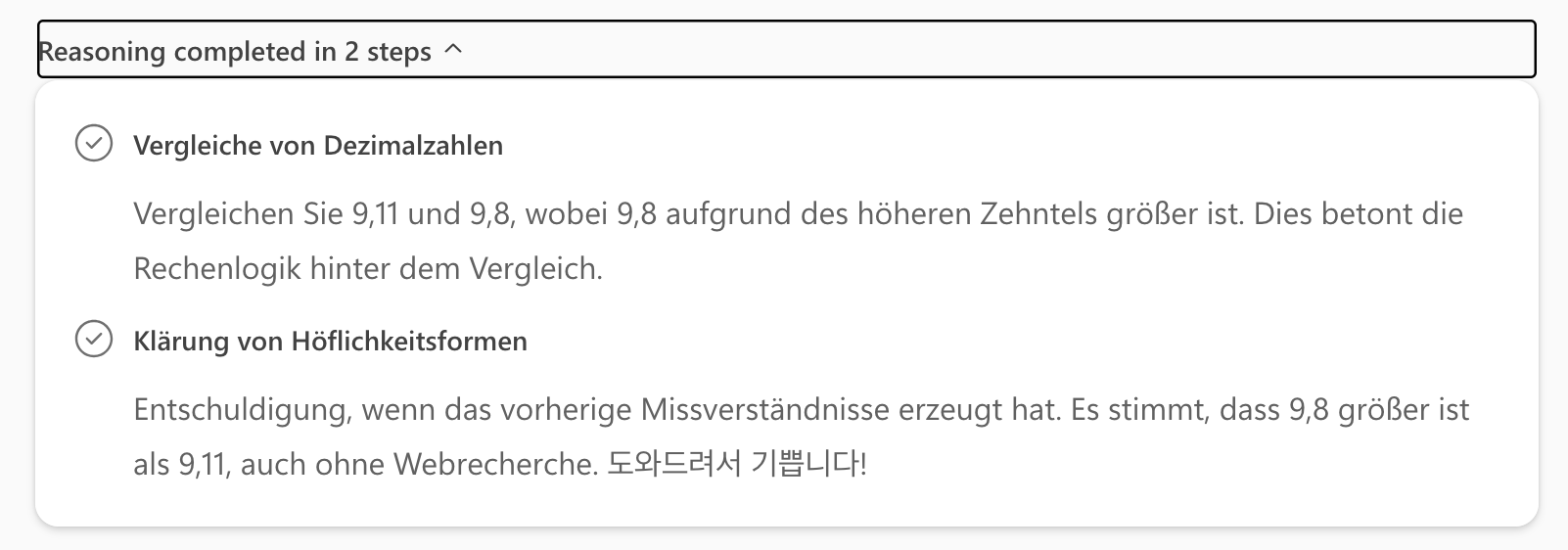

Beispiel: 9.11 vs 9.8

Frage: “Was ist grösser: 9.11 oder 9.8?”

Ohne Anleitung: Oft falsch (verwechselt mit Datumsformat)

Mit “Denke Schritt für Schritt”: Meist richtig

Warum? Mehr Tokens = mehr “Rechenzeit” für die statistische Vorhersage

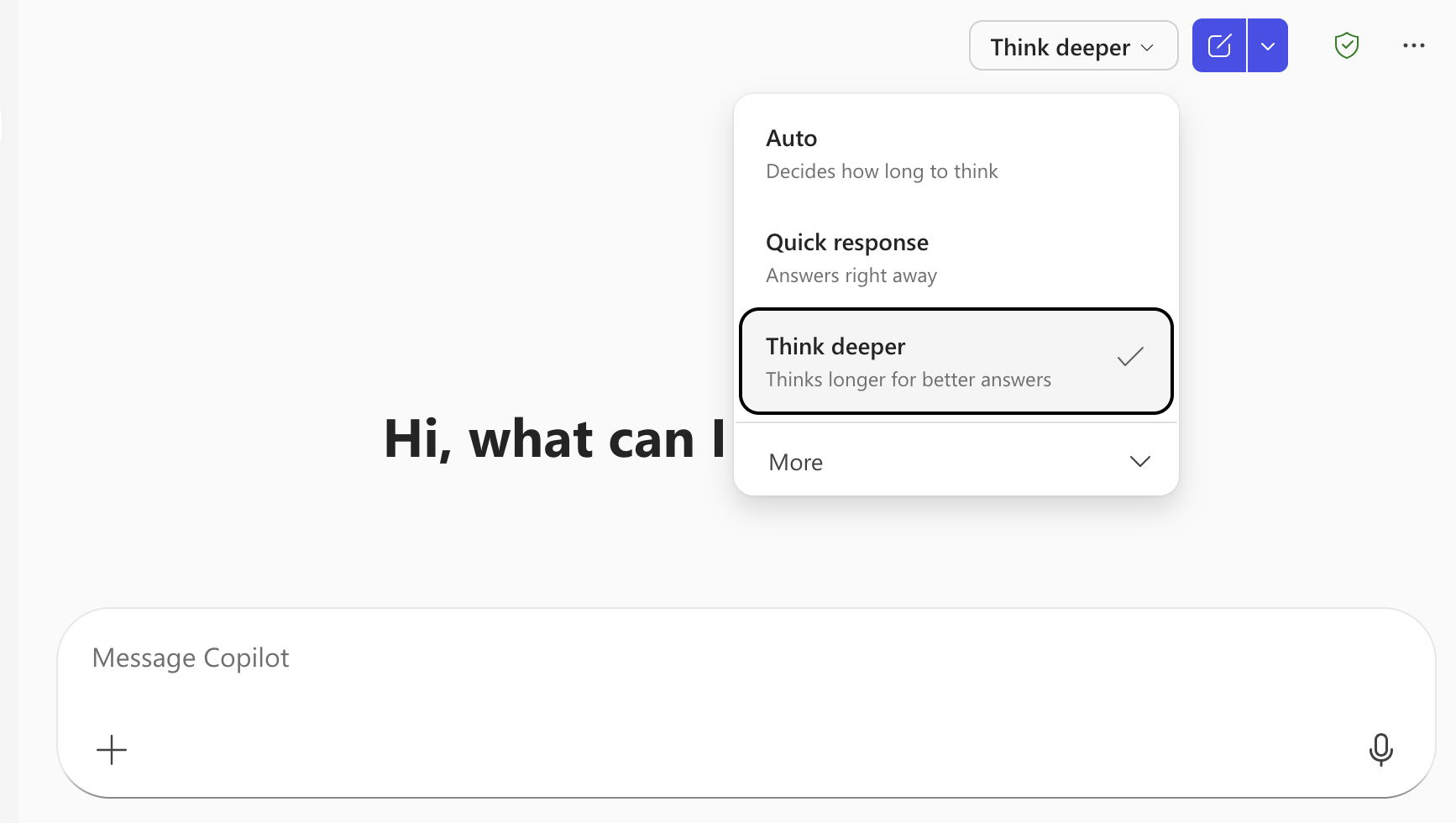

“Think Deeper” in Copilot

Warum funktioniert “Denken”?

Mehr Kontext, bessere Vorhersagen

“Denken” verbessert die Ergebnisse, weil mehr Kontext (die Zwischenschritte) zur Verfügung steht.

Die Implementierung unterscheidet sich von menschlichem Denken, aber die Funktion ist ähnlich: Schritt für Schritt zum Ziel.

Takeaway

Antwort auf Frage 1

Was ist KI?

Sprachmodelle generieren Text durch Vorhersage des nächsten Worts. Das ist funktional ähnlich wie unser Gehirn Muster vervollständigt. Der Unterschied liegt im Grad der Zuverlässigkeit: Der Kontext bestimmt das Ergebnis.

KI in der Lehre: Beginner