Wie funktionieren Chatbots?

12 November, 2025

Was sind Chatbots?

Was sind LLMs?

Ein LLM kann man sich wie einen ausgefeilten Autocomplete-Mechanismus vorstellen.

Bildquelle: www.apple.com

Was sind LLMs?

- Statistische Modelle, die Text analysieren, um das nächste Wort vorherzusagen.

\[ \newcommand{\green}[1]{\color{green}{#1}} \newcommand{\purple}[1]{\color{purple}{#1}} \newcommand{\red}[1]{\color{red}{#1}} \newcommand{\blue}[1]{\color{blue}{#1}} \]

\[\green{P(\text{Wort}_{i+1}} \mid \red{\text{Kontext}}, \blue{\text{Modell}})\]

- Jede \(\purple{\text{Vorhersage}}\) basiert auf dem \(\blue{\text{Kontext}}\) und dem internen \(\red{\text{Modell}}\).

Vorhersage

Nicht alle Teile des Kontexts sind gleich wichtig:

“Die Familie, die sehr wohlhabend war, lebte in einem grossen Haus. Das Haus stand inmitten eines weitläufigen Gartens. Es war bekannt für seine prächtige Fassade und die grosszügigen _“

Nach Thomas Mann, Buddenbrooks

Welche Wörter sind besonders wichtig, um

- die Bedeutung des Satzes zu erfassen?

- das nächste Wort vorherzusagen?

Kontext verstehen

“Die Familie, die sehr wohlhabend war, lebte in einem grossen Haus. Das Haus stand inmitten eines weitläufigen Gartens. Es war bekannt für seine prächtige Fassade und die grosszügigen ___”

Syntaktische Struktur (Grammatik und Struktur des Satzes):

- Das Wort “grosszügigen” ist ein Adjektiv, das wahrscheinlich ein Nomen—im Plural—beschreibt (Dativ oder Akkusativ wegen der Endung “-en”).

- Der Satz bezieht sich auf das Haus und den Garten, daher liegt der Fokus vermutlich auf deren Eigenschaften.

Semantischer Kontext (Bedeutung):

Die Beschreibung hebt Wohlstand hervor. Das nächste Wort beschreibt vermutlich etwas Luxuriöses oder Weitläufiges.

Lexikalische Kohärenz (Wörter und deren Bedeutungen im Kontext):

Nach “grosszügigen” folgen häufig Nomen, die Räume, Flächen oder architektonische Elemente beschreiben, z. B. “Räume”, “Gärten”, “Fenster”.

Wie generieren LLMs Text?

\[ \newcommand{\green}[1]{\color{green}{#1}} \newcommand{\purple}[1]{\color{purple}{#1}} \newcommand{\red}[1]{\color{red}{#1}} \newcommand{\blue}[1]{\color{blue}{#1}} \]

\[\green{P(\text{Wort}_{i+1}} \mid \red{\text{Kontext}}, \blue{\text{Modell}})\]

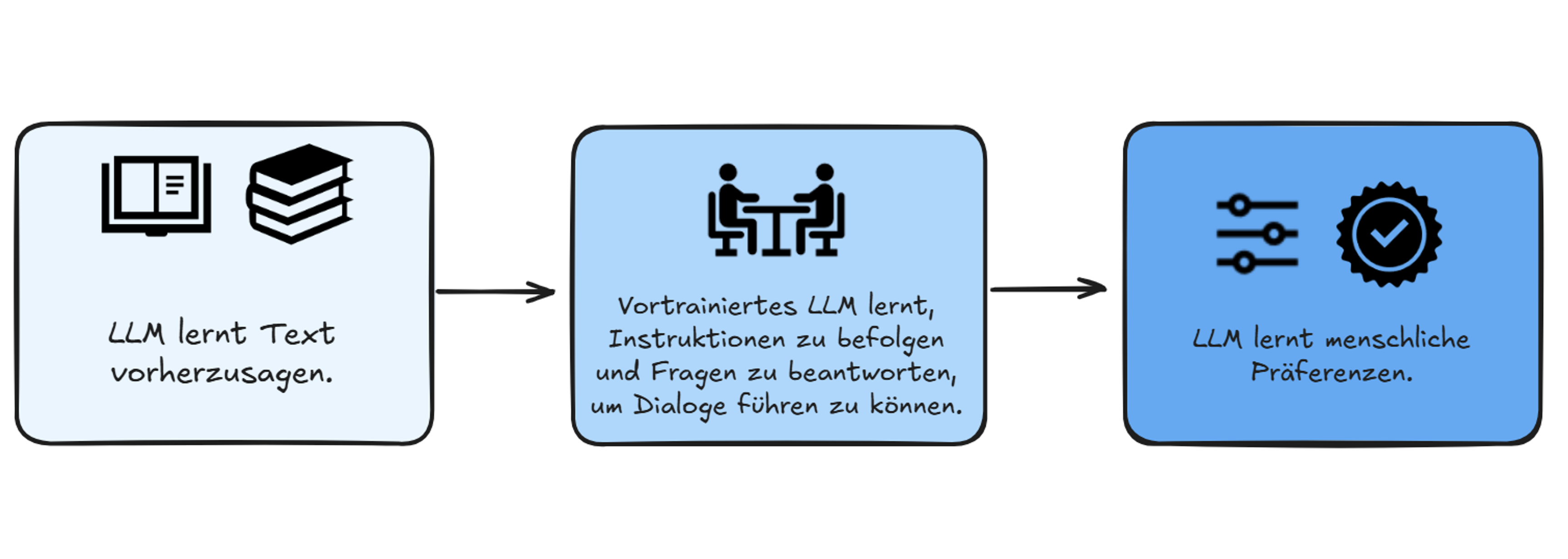

Wie werden LLMs trainiert?

Extended Thinking: Wenn LLMs nachdenken

Von Textgenerierung zu Reasoning Neuere Modelle (o0/o3, GPT-5, Claude Opus/Sonnet/Haiku) können “nachdenken” bevor sie eine Antwort generieren:

- Problem analysieren: Aufgabe in Teilschritte zerlegen

- Optionen durchdenken:Verschiedene Ansätze prüfen

- Reasoning-Kette aufbauen: Schritte logisch verbinden

- Antwort generieren: Basierend auf Thinkink-Output

Vorteil: Bessere Antworten bei komplexen Aufgaben (Planung, Problemlösung, Mathematik)

Nachteil: Langsamer und teurer als Standard-Modus

Standard-Modus

Frage → Antwort

Schnell, direkt

Thinking-Modus

Frage → <denkt nach…> → Antwort

Langsam, gründlich

Gefahren und Herausforderungen

Die verschiedenen Stufen des Trainings sind mit verschiedenen Arten von Bedenken verbunden:

- Urheberrecht: Die trainierten Modelle werden mit Texten trainiert, die möglicherweise Urheberrechtlich geschützt sind.

- Bias: Die trainierten Modelle können bestehende Vorurteile aus den Trainingsdaten lernen.

- Energieverbrauch: Das Training der Modelle verbraucht viel Energie und ist damit umweltbelastend.

- Sycophancy: Die Modelle neigen dazu, die Meinungen oder Präferenzen ihrer Benutzer zu bestätigen.

Gefahren und Herausforderungen

- Obschon sich LLMs viel Wissen aneignen1, werden sie nicht trainiert, faktisch korrekte Aussagen zu machen.

- Dies bedeutet, dass wir alle Aussagen, die LLMs uns präsentieren, immer kritisch hinterfragen müssen.

- LLMs sind keine Wissensdatenbanken. Informationen immer anhand externer Quellen überprüfen.

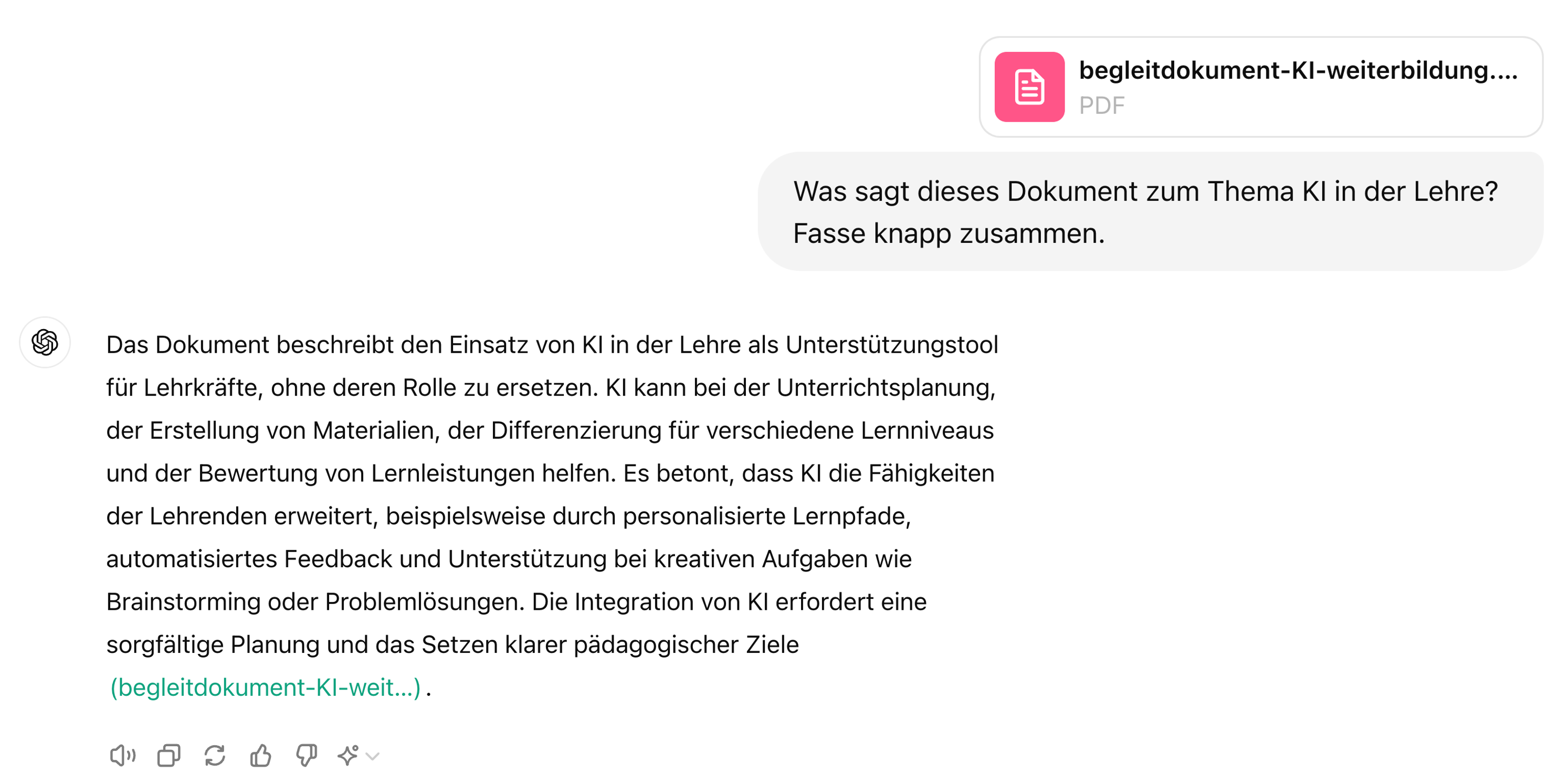

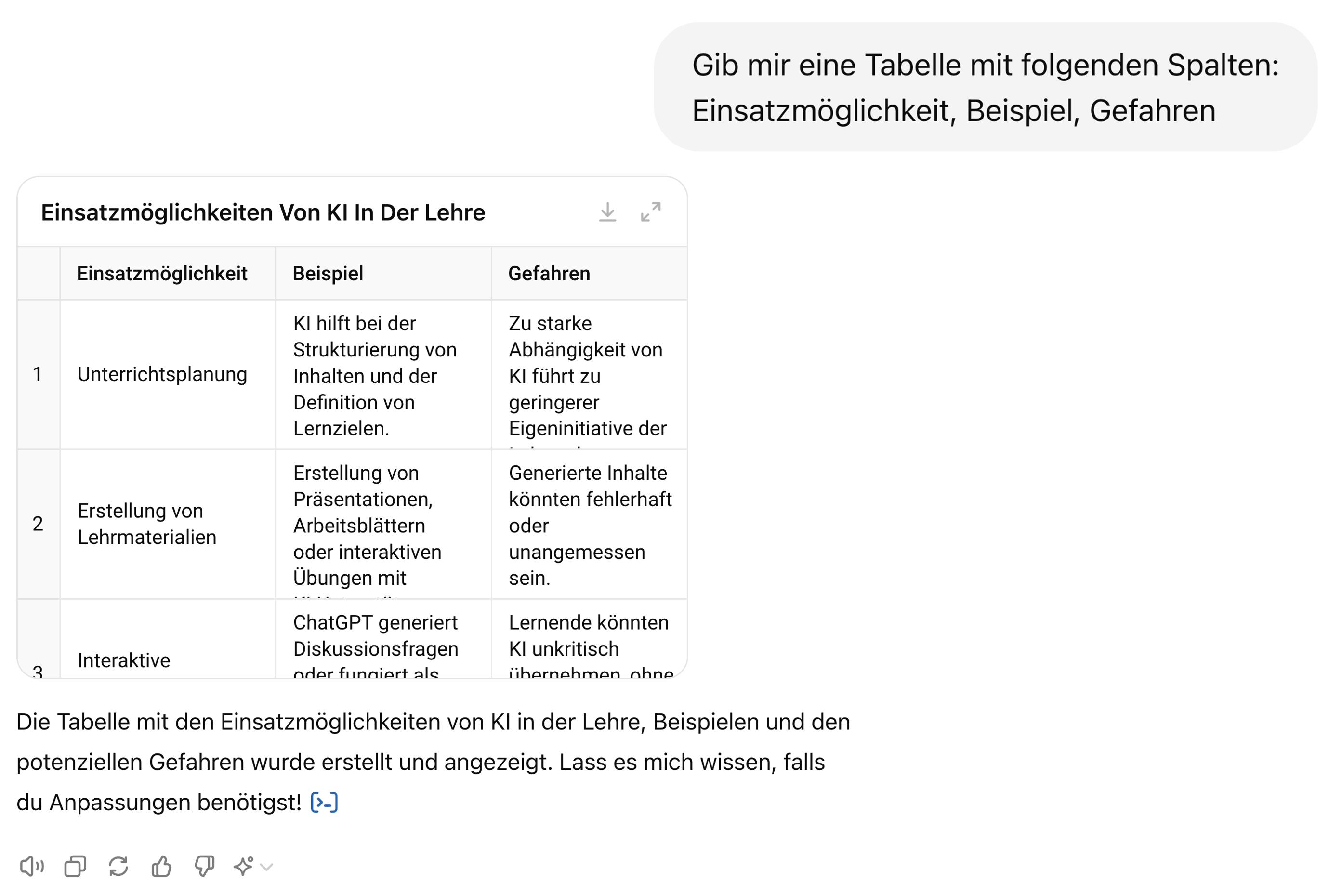

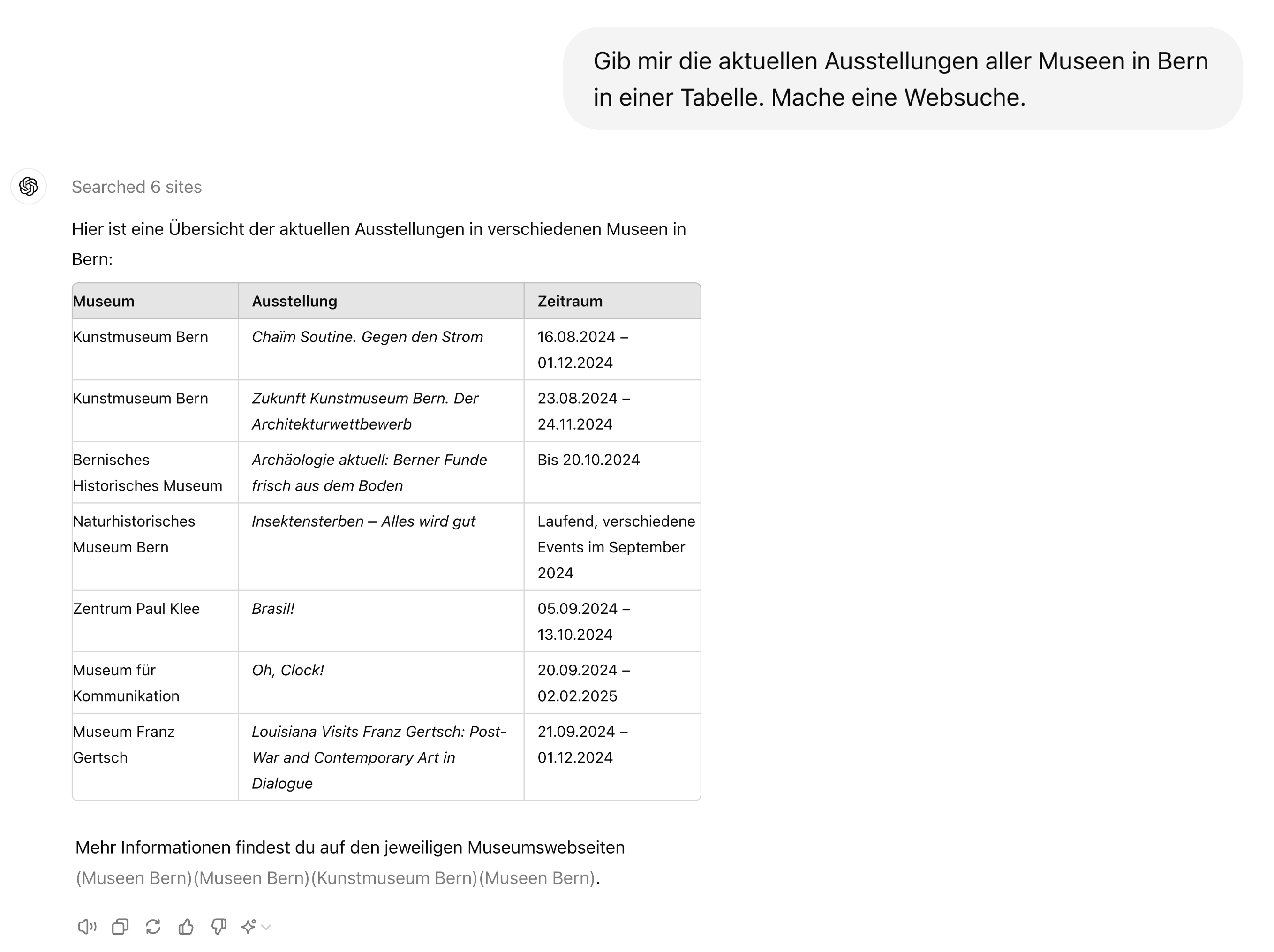

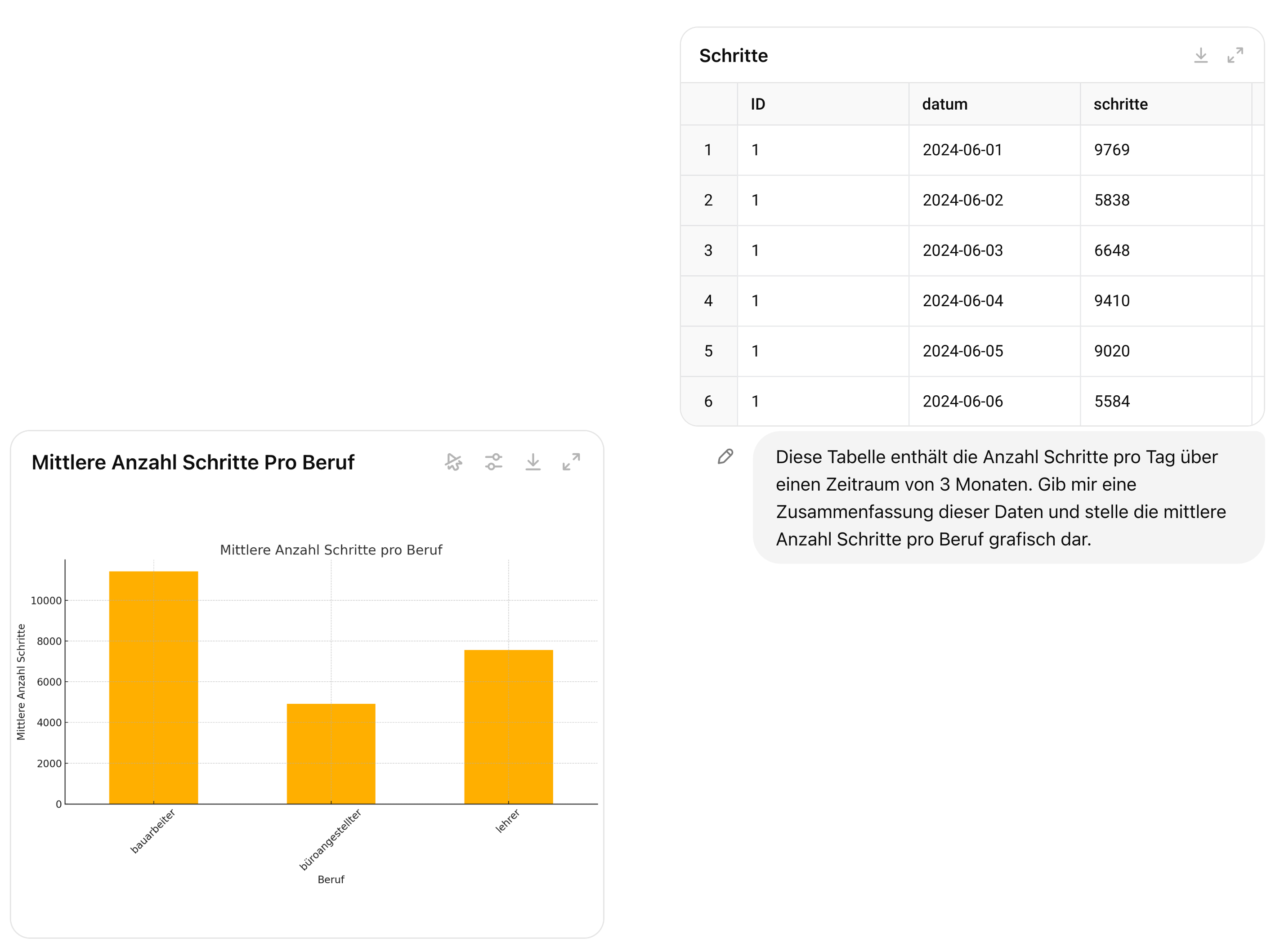

ChatGPT

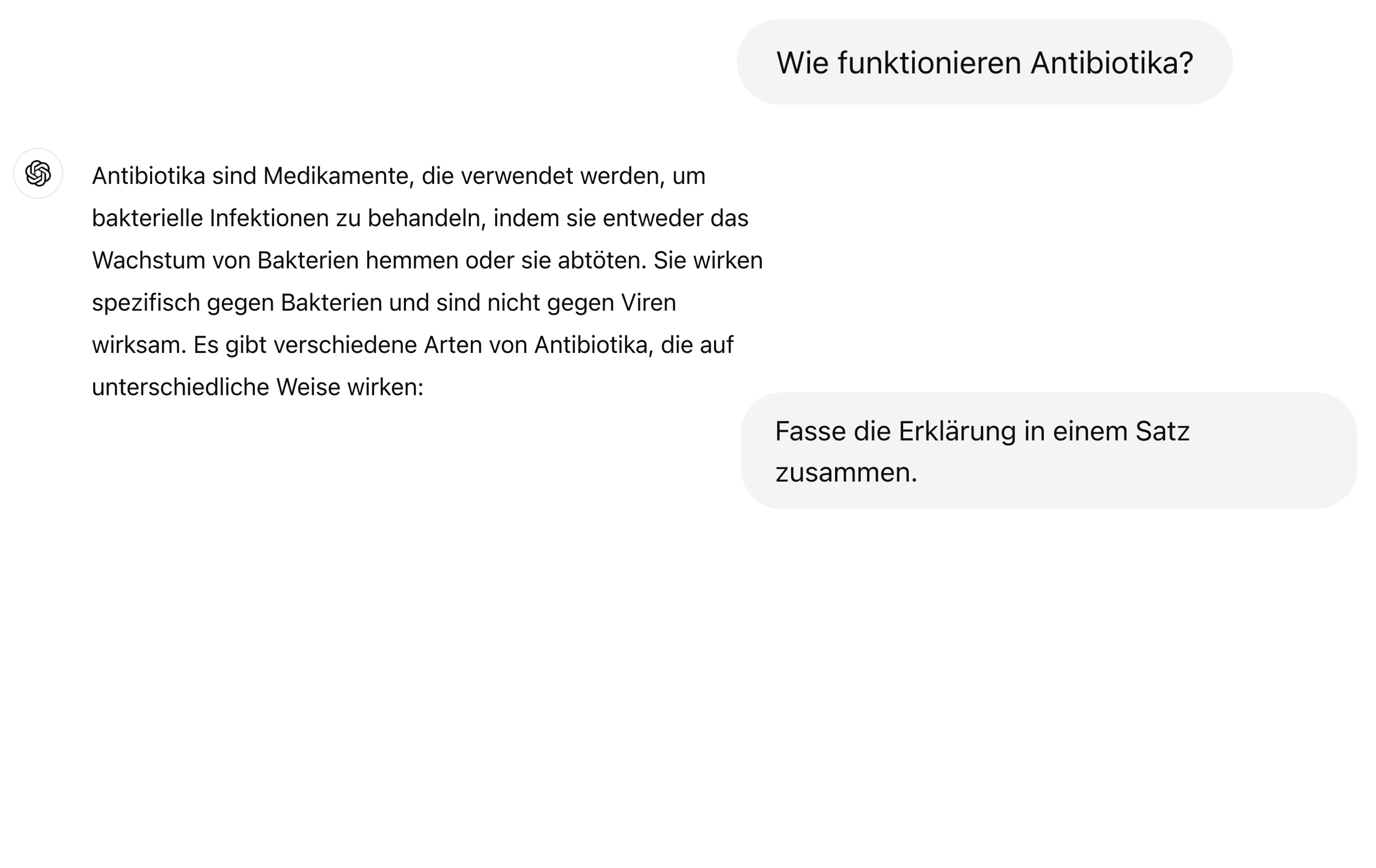

Fragen beantworten

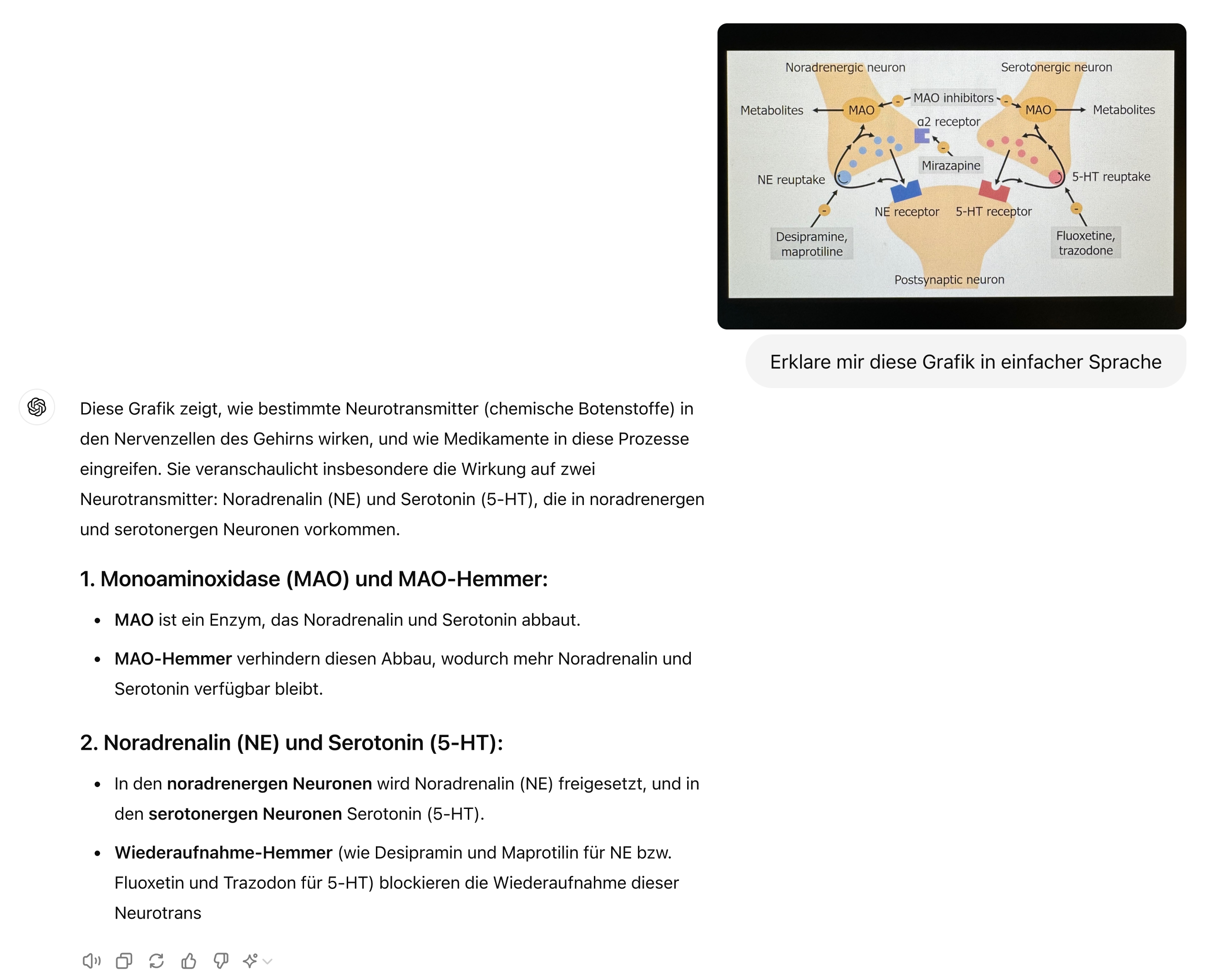

Bilder analysieren

Dokumente zusammenfassen

Output strukturieren

Websuche

Datenanalyse

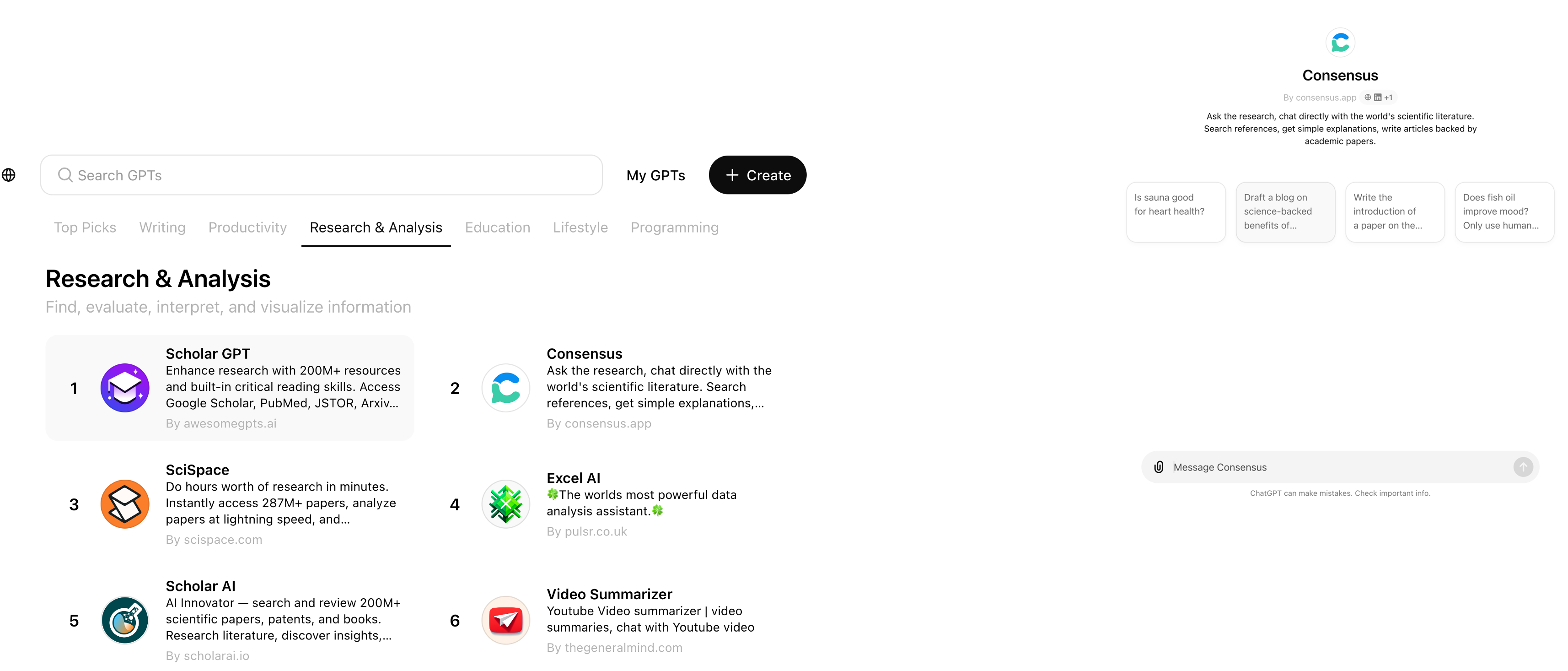

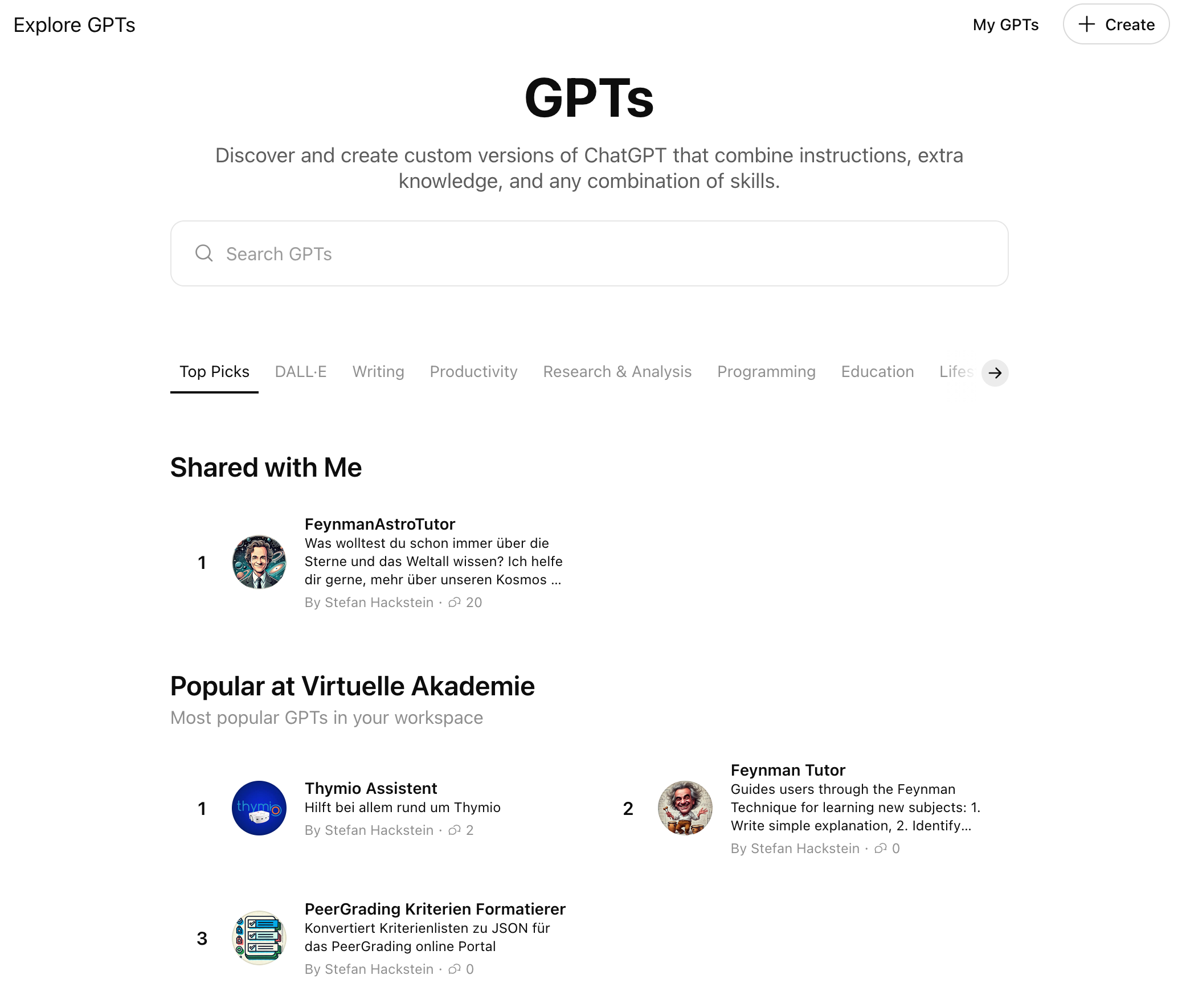

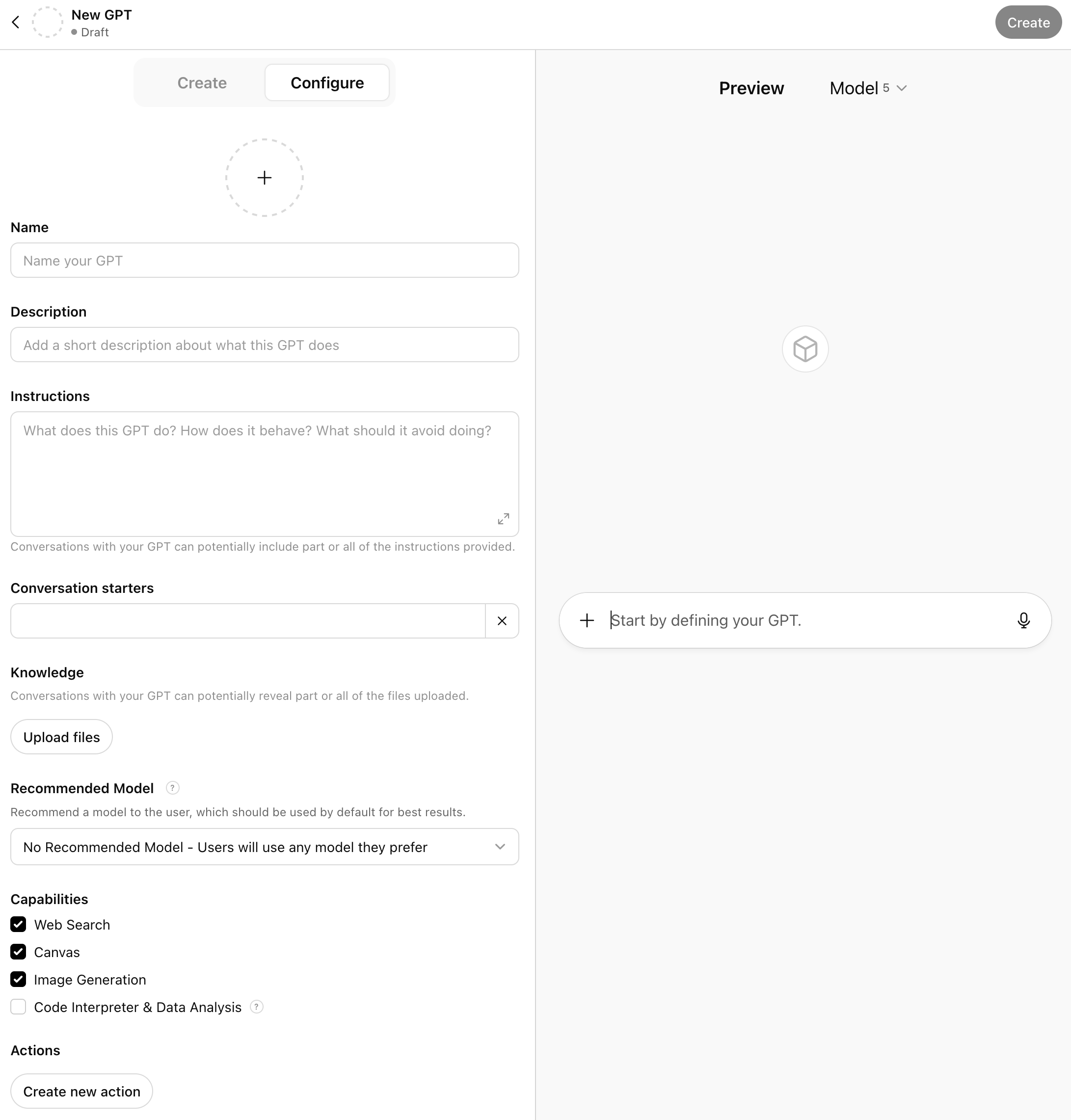

Custom GPTs

Der Paradigmenwechsel

Traditional Chatbot

Benutzer: “Plane eine Reise nach Paris”

Chatbot:

- “Hier sind 5 Hotels in Paris…”

- “Diese Flüge sind verfügbar…”

- “Sehenswürdigkeiten: Eiffelturm…”

- Du musst alles selbst buchen

AI Agent

Benutzer: “Plane eine Reise nach Paris”

Agent:

- Checkt deinen Kalender

- Bucht Flug und Hotel

- Erstellt Reiseroute

- Sendet Bestätigungen

- Erledigt die komplette Aufgabe

Der Unterschied: Ein Chatbot kann eine Frage beantworten. Ein Agent bearbeitet das Problem, bis der Job erledigt ist.

Was sind AI Agents?

LLM + Gedächtnis + Werkzeuge + Entscheidungsschleife

LLM-basierte Agenten =

- LLM (GPT-5, Claude, …) für Reasoning

- + Gedächtnis

- + Werkzeuge (Tools) (APIs, Datenbanken, Code)

- + Entscheidungsschleife (kontinuierlich)

Der Agent-Zyklus

- Wahrnehmung: Input/Umgebung

- Planung: LLM überlegt Schritte

- Handlung: Tools/APIs verwenden

- Feedback: Ergebnisse bewerten

Von Chatbot zu Agent: Unterschiedie

Zwei verschiedene Paradigmen

| Dimension | Chatbot | AI Agent |

|---|---|---|

| Verhalten | • Reaktiv: Antwortet nur auf Anfragen | • Proaktiv: Arbeitet kontinuierlich zum Ziel |

| Aufgaben | • Einzelne Antworten • Session-basiert |

• Komplette Workflows • End-to-End Execution |

| Gedächtnis | • Nur während Konversation (im Kontext) • Kein Lernen |

• Persistent über Zeit • Lernt aus Interaktionen (speichert “Memories”) |

| Tools | • Keine externen Integrationen | • APIs, Datenbanken, Apps • Real-time Integration |

| Planung | • Keine Strategieentwicklung | • Multi-step Planning • Selbstkorrektur |

ChatGPT: GPTs

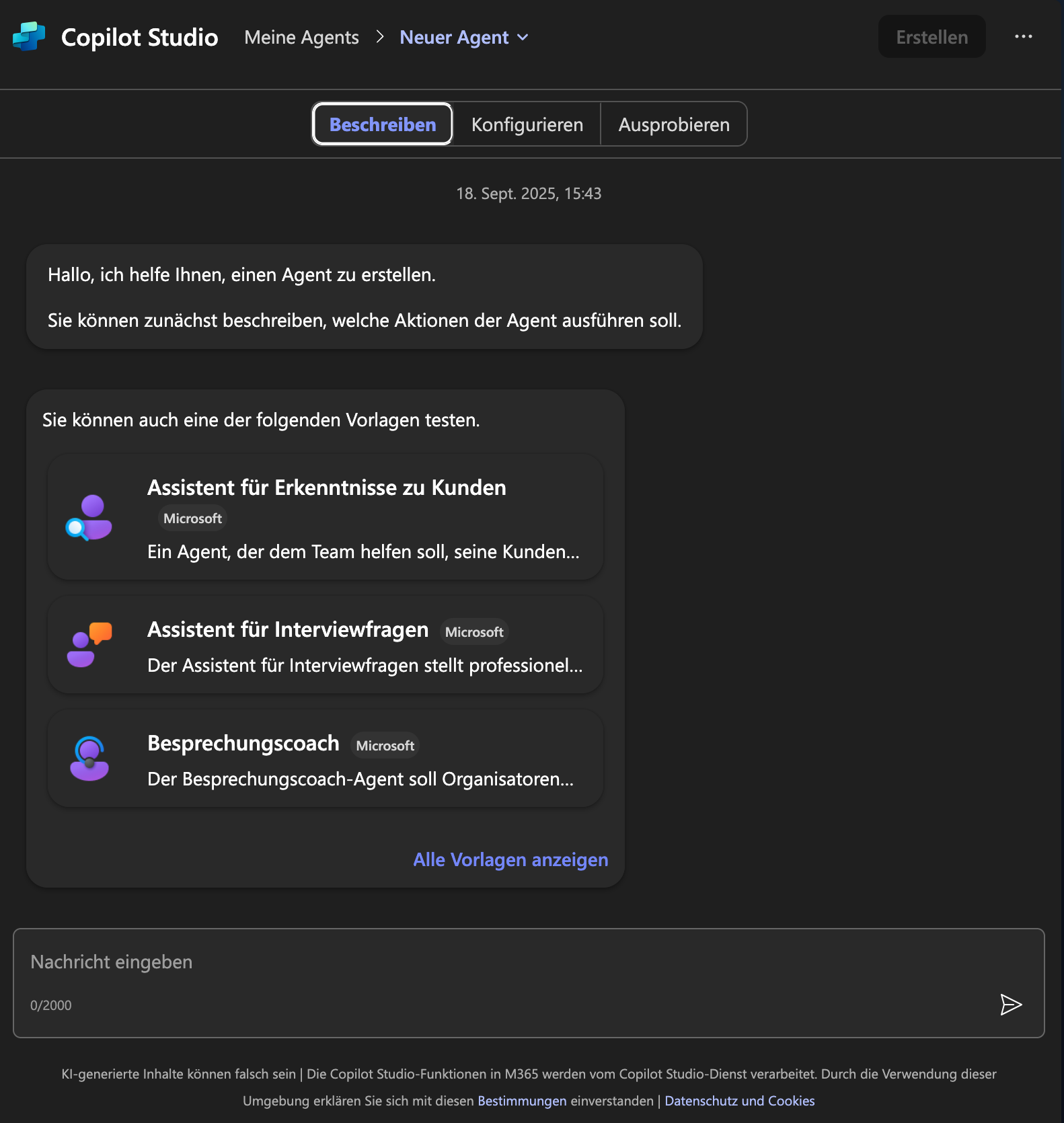

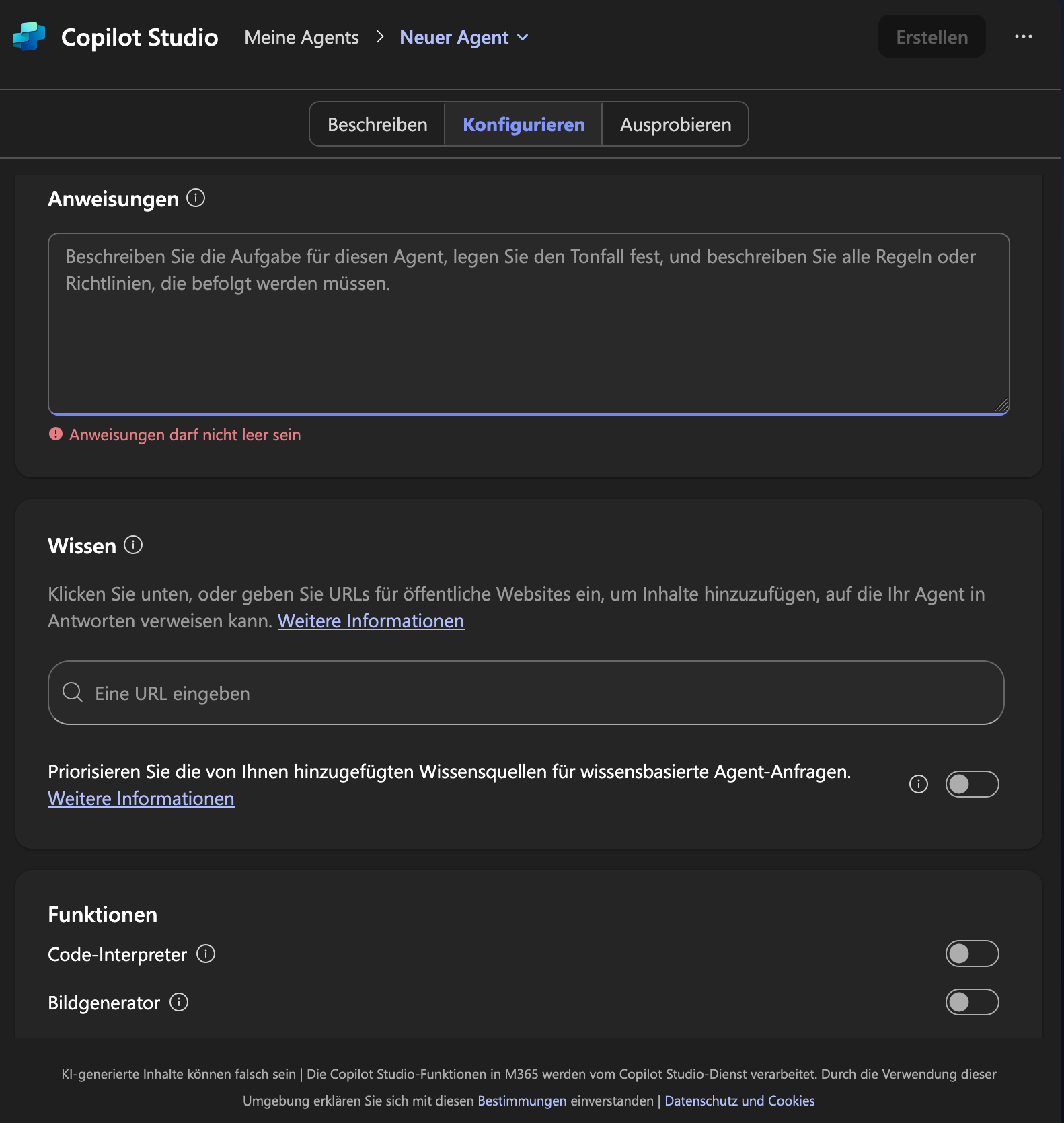

Copilot Agents

Berner Fachhochschule | Bern University of Applied Sciences